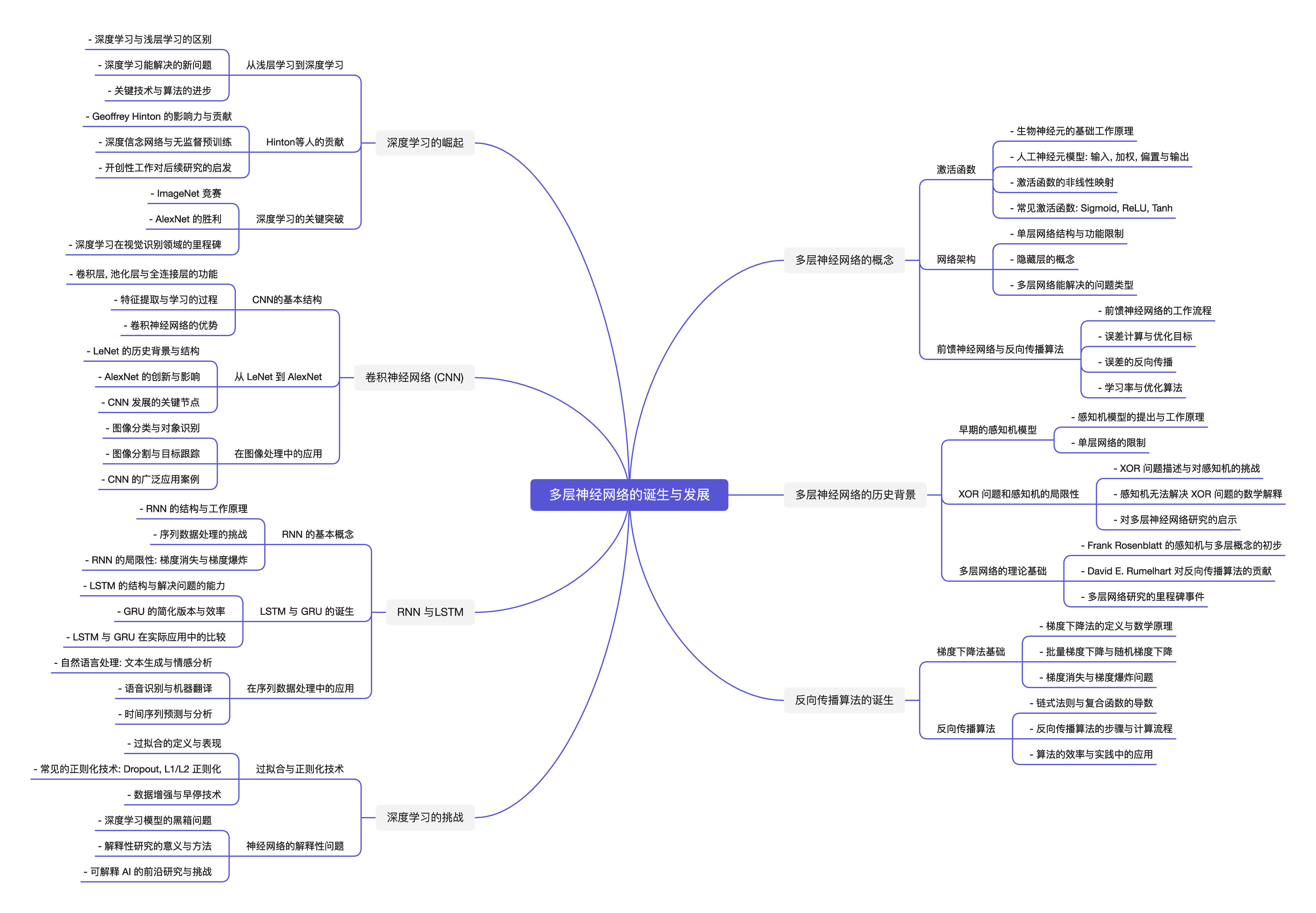

### 多层神经网络的概念

- 激活函数

- 网络架构

- 前馈神经网络与反向传播算法

### 激活函数

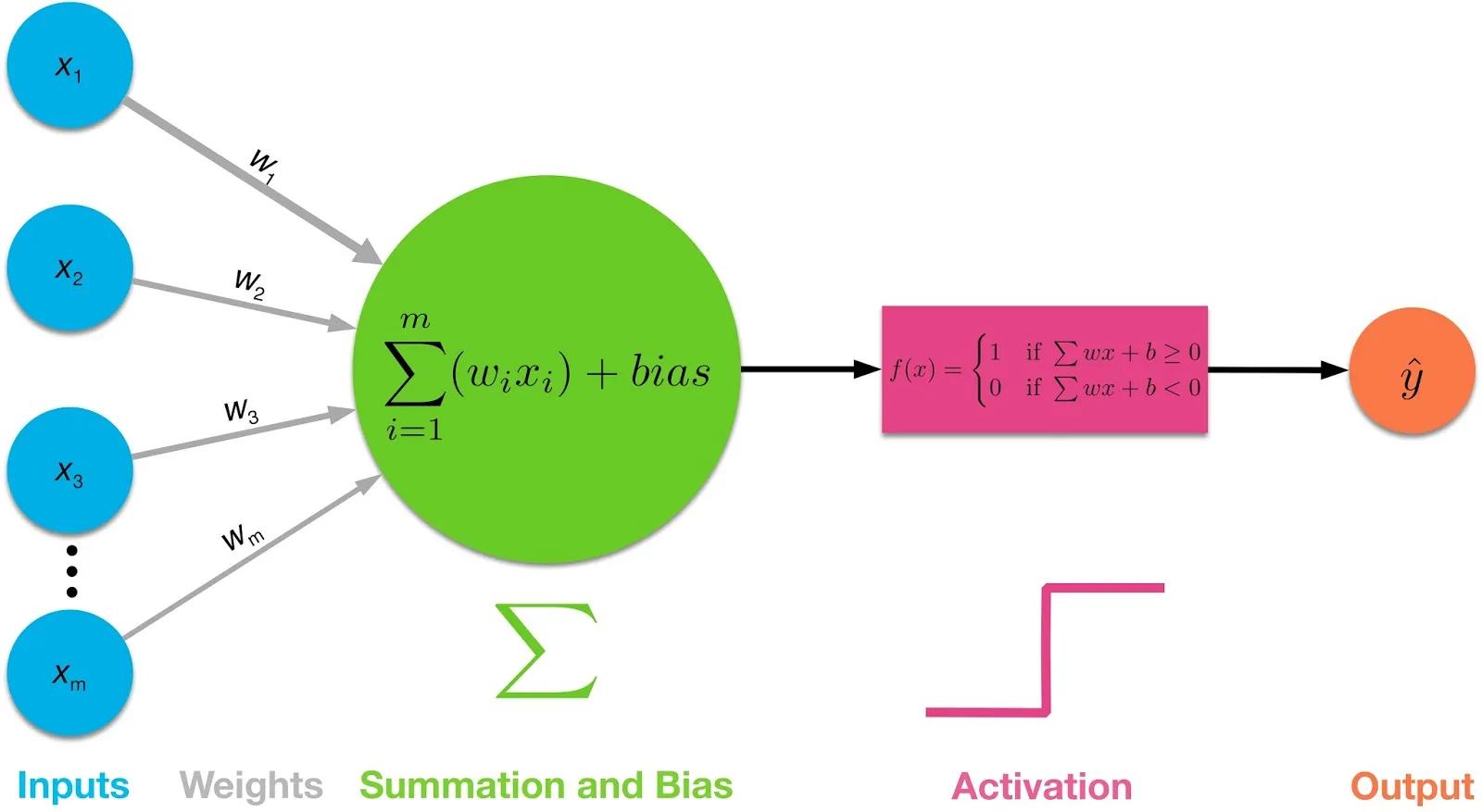

- 生物神经元的基础工作原理

- 人工神经元模型: 输入, 加权, 偏置与输出

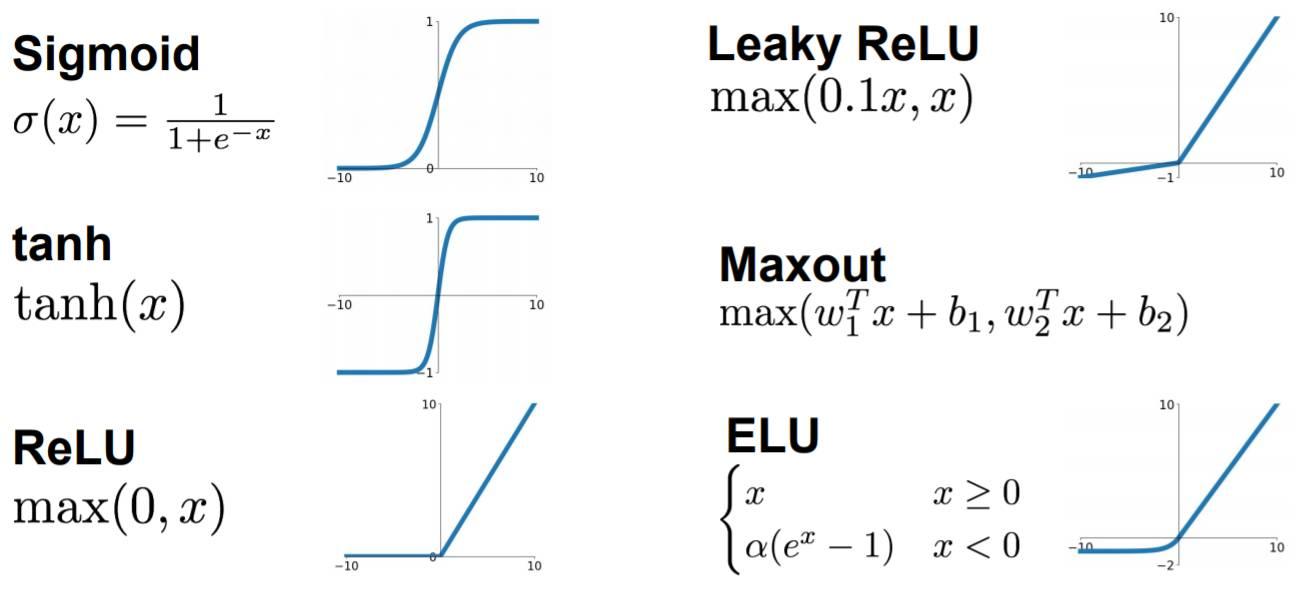

- 激活函数的非线性映射

- 常见激活函数: Sigmoid, ReLU, Tanh

#### Neuron

#### Activition Functions

### 网络架构

- 单层网络结构与功能限制

- 隐藏层的概念

- 多层网络能解决的问题类型

### 前馈神经网络与反向传播算法

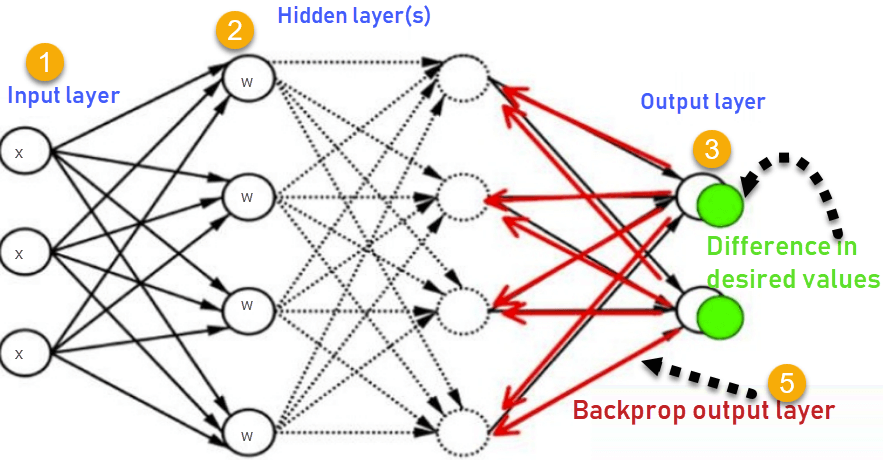

- 前馈神经网络的工作流程

- 误差计算与优化目标

- 误差的反向传播

- 学习率与优化算法

#### Backpropatation Algorithm

### 多层神经网络的历史背景

- 早期的感知机模型

- XOR 问题和感知机的局限性

- 多层网络的理论基础: 从 Rosenblatt 到 Rumelhart

### 早期的感知机模型

- 感知机模型的提出与工作原理

- 单层网络的限制

### XOR 问题和感知机的局限性

- XOR 问题描述与对感知机的挑战

- 感知机无法解决 XOR 问题的数学解释

- 对多层神经网络研究的启示

### 多层网络的理论基础

- Frank Rosenblatt 的感知机与多层概念的初步

- David E. Rumelhart 对反向传播算法的贡献

- 多层网络研究的里程碑事件

### 反向传播算法的诞生

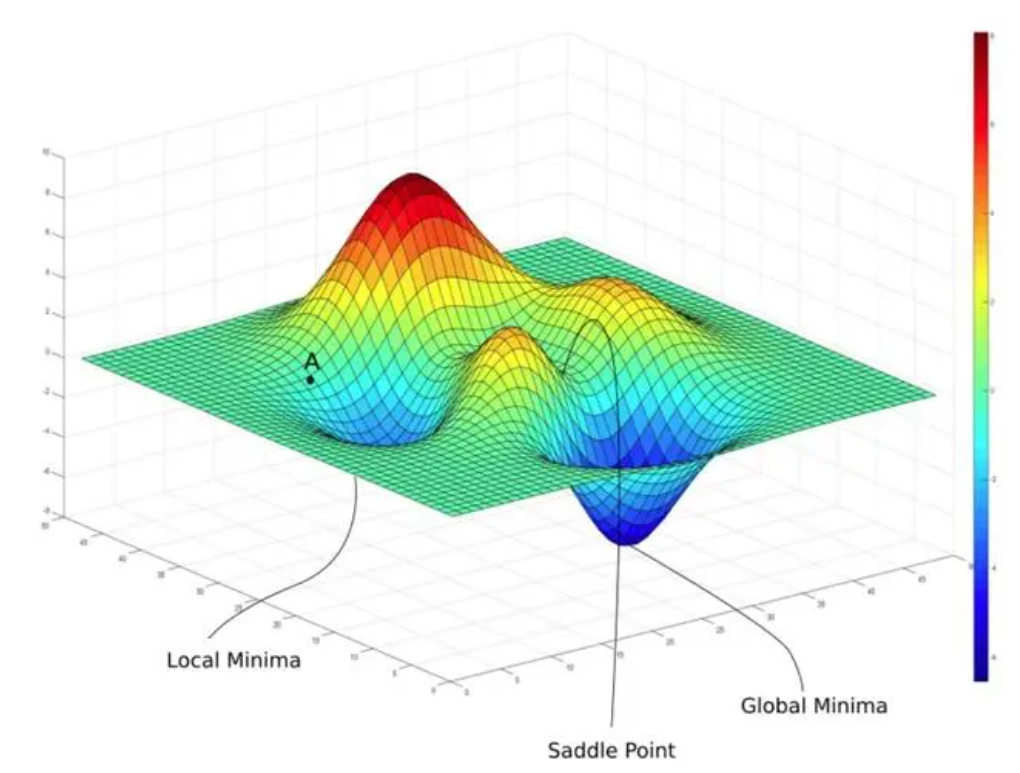

- 梯度下降法基础

- 反向传播算法

### 梯度下降法基础

- 梯度下降法的定义与数学原理

- $$ \theta\_\{next\} = \theta\_\{current\} - \eta \cdot \nabla\_\theta J(\theta) $$

- $ \theta $ 是参数, $ \eta $ 是学习率, $ J(\theta) $ 是损失函数

- $ \nabla_\theta J(\theta) $ 是损失函数相对于 $ \theta $ 的梯度

- 批量梯度下降与随机梯度下降

- 梯度消失与梯度爆炸问题

#### Gradient Descent

### 反向传播算法

- 链式法则与复合函数的导数

- 反向传播算法的步骤与计算流程

- 算法的效率与实践中的应用

### 深度学习的崛起

- 从浅层学习到深度学习

- Hinton 等人的贡献

- ImageNet 挑战赛与深度学习的关键突破

### 从浅层学习到深度学习

- 深度学习与浅层学习的区别

- 深度学习能解决的新问题

- 关键技术与算法的进步

### Hinton等人的贡献

- Geoffrey Hinton 的影响力与贡献

- 深度信念网络与无监督预训练

- 开创性工作对后续研究的启发

### 深度学习的关键突破

- ImageNet 竞赛

- AlexNet 的胜利

- 深度学习在视觉识别领域的里程碑

### 卷积神经网络 (CNN)

- CNN 的基本结构

- 从 LeNet 到 AlexNet

- 在图像处理中的应用

#### Convolutional Neural Network

#### Convolutional Neural Network

#### Convolutional Neural Network

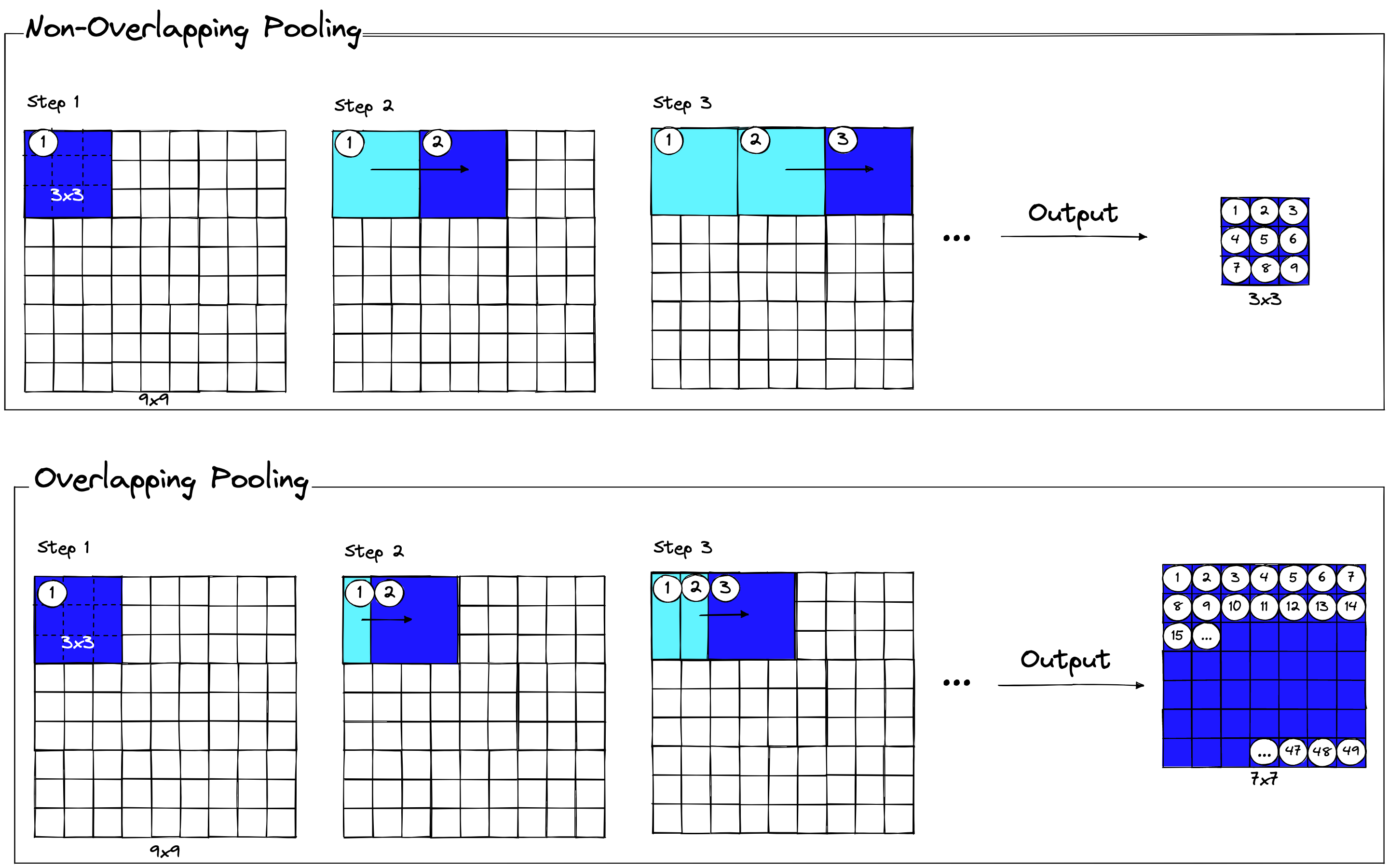

### CNN的基本结构

- 卷积层, 池化层与全连接层的功能

- 特征提取与学习的过程

- 卷积神经网络的优势

### 从 LeNet 到 AlexNet

- LeNet 的历史背景与结构

- AlexNet 的创新与影响

- CNN 发展的关键节点

### 在图像处理中的应用

- 图像分类与对象识别

- 图像分割与目标跟踪

- CNN 的广泛应用案例

### RNN 与LSTM

- RNN 的基本概念

- LSTM 与 GRU 的诞生

- 在序列数据处理中的应用

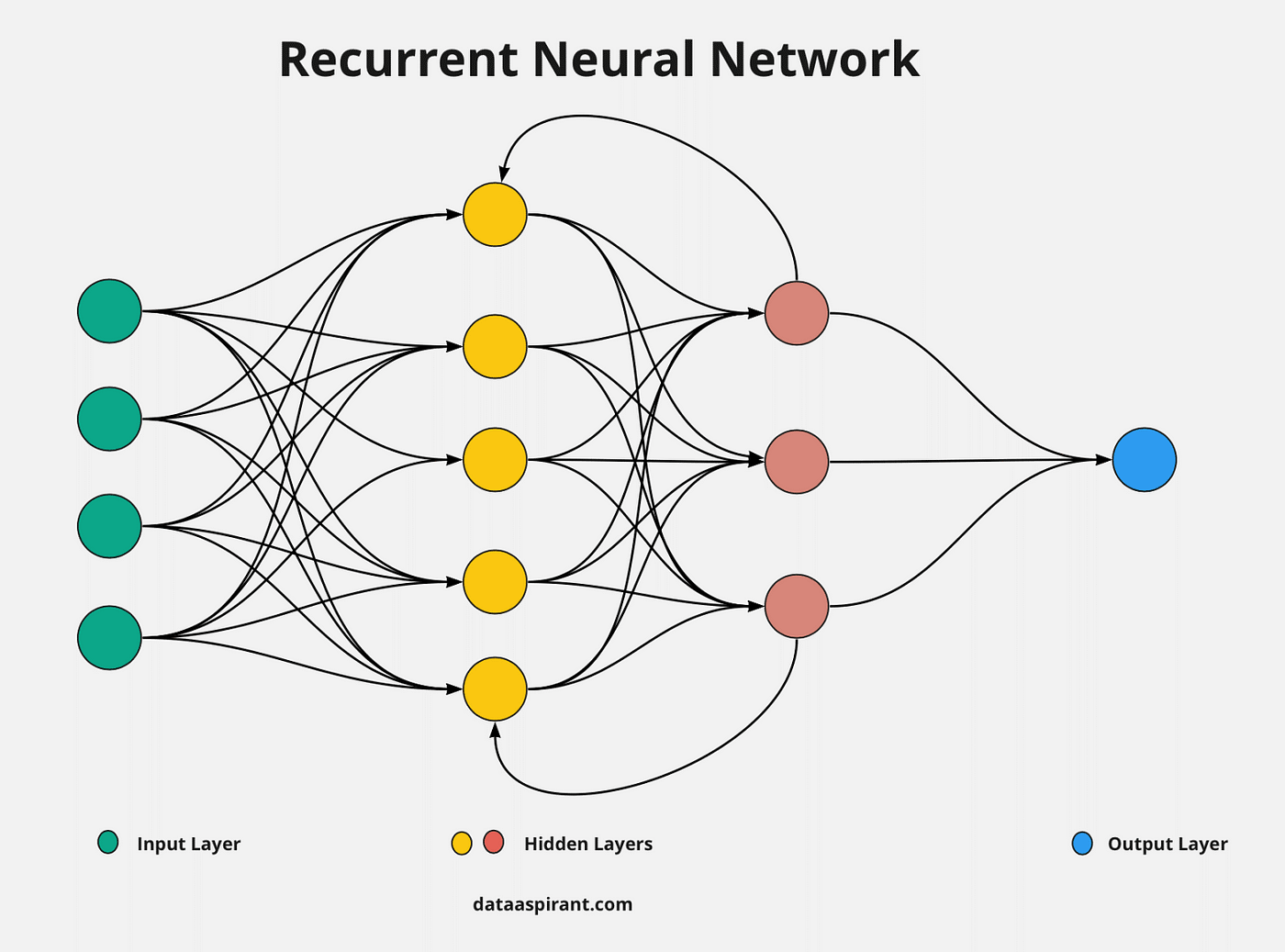

### RNN 的基本概念

- RNN 的结构与工作原理

- 序列数据处理的挑战

- RNN 的局限性: 梯度消失与梯度爆炸

#### Recurrent Neural Network

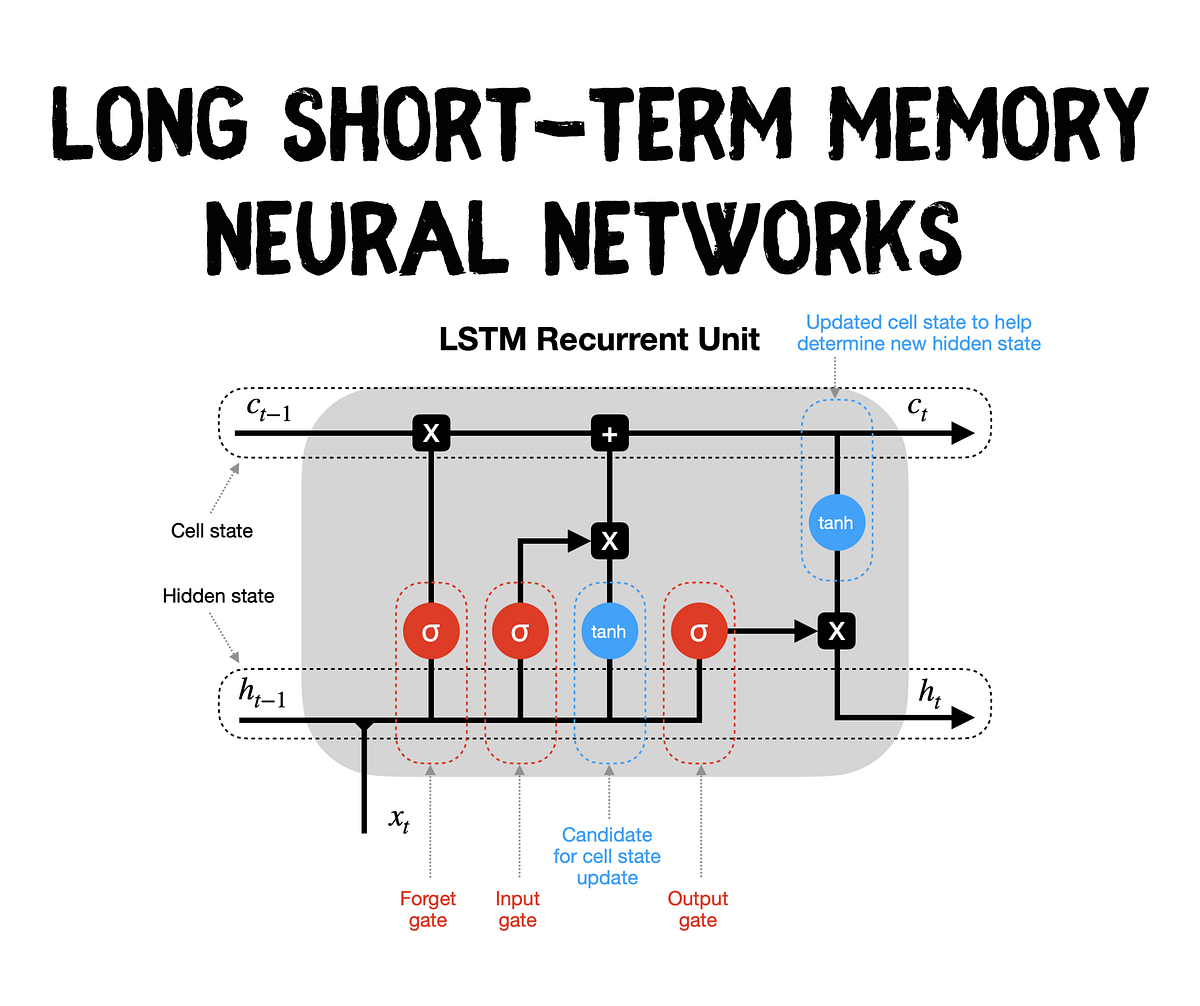

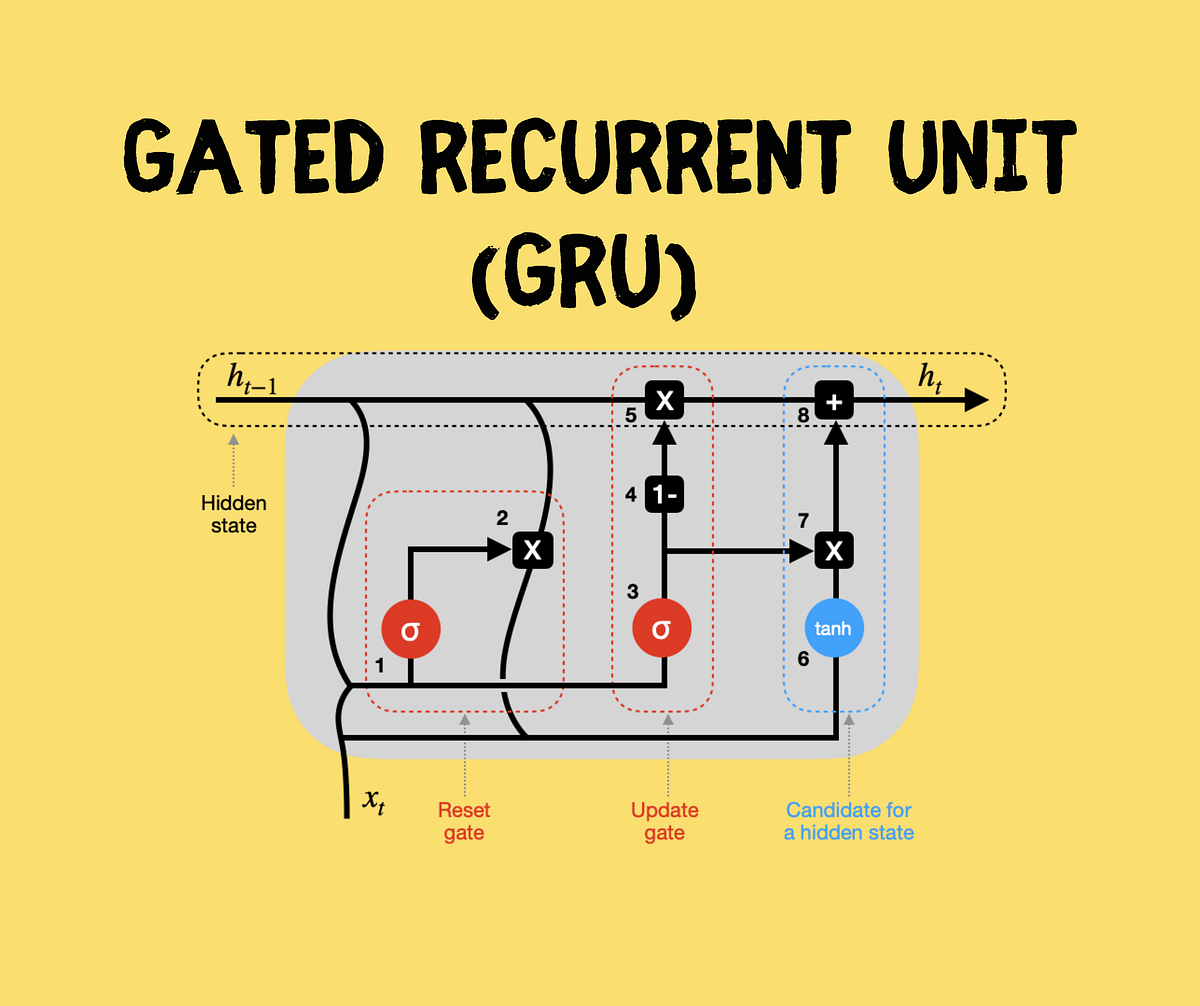

### LSTM 与 GRU 的诞生

- LSTM 的结构与解决问题的能力

- GRU 的简化版本与效率

- LSTM 与 GRU 在实际应用中的比较

#### Long Short-Term Memory

#### Gated Recurrent Unit

### 在序列数据处理中的应用

- 自然语言处理: 文本生成与情感分析

- 语音识别与机器翻译

- 时间序列预测与分析

### 深度学习的挑战

- 过拟合与正则化技术

- 神经网络的解释性问题

### 过拟合与正则化技术

- 过拟合的定义与表现

- 常见的正则化技术: Dropout, L1/L2 正则化

- 数据增强与早停技术

### 神经网络的解释性问题

- 深度学习模型的黑箱问题

- 解释性研究的意义与方法

- 可解释 AI 的前沿研究与挑战

### 2.2 多层神经网络的诞生与发展

- 激活函数的作用是什么?

- 解释单层网络和多层网络在解决问题上的主要区别.

- 反向传播算法在训练神经网络中扮演什么角色?

- 描述梯度下降法的基本原理.

- CNN 与 RNN 在结构上的主要区别是什么?

- 为什么深度学习模型被认为是黑箱?

----

[ 2.1 机器学习的概念与原理](ita-2-1.html#/overview)

[| 练习 |](ita-exec.html)

[ 2.3 深度学习的原理与应用](ita-2-3.html#/overview)